SK Hynix Inc. đang tăng cường chi tiêu cho việc đóng gói chip tiên tiến, với hy vọng đáp ứng được nhiều hơn nhu cầu ngày càng tăng đối với một thành phần quan trọng trong phát triển trí tuệ nhân tạo: bộ nhớ băng thông cao.

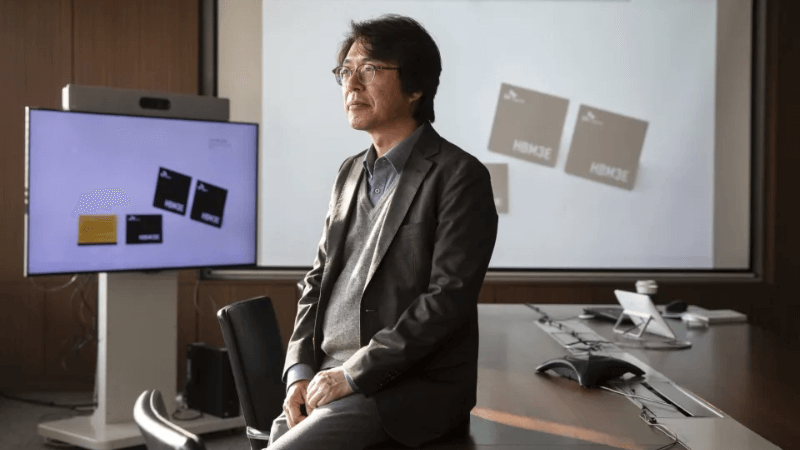

Lee Kang Wook – cựu kỹ sư của Samsung Electronics Co., hiện đang đứng đầu bộ phận phát triển bao bì tại SK Hynix cho biết công ty có trụ sở tại Icheon này đang đầu tư hơn 1 tỷ USD vào Hàn Quốc trong năm nay để mở rộng và cải tiến những bước cuối cùng trong quá trình sản xuất chip. Sự đổi mới với quy trình đó là lợi thế cốt lõi của HBM với tư cách là bộ nhớ AI được tìm kiếm nhiều nhất và những tiến bộ hơn nữa sẽ là chìa khóa để giảm mức tiêu thụ điện năng, thúc đẩy hiệu suất và củng cố vị trí dẫn đầu của công ty trên thị trường HBM.

Ông Lee chuyên về các phương pháp kết hợp và kết nối chất bán dẫn tiên tiến vốn ngày càng trở nên quan trọng nhờ sự ra đời của AI hiện đại và khả năng xử lý kho dữ liệu khổng lồ thông qua chuỗi xử lý song song. Mặc dù SK Hynix chưa tiết lộ ngân sách chi tiêu vốn của mình trong năm nay nhưng ước tính trung bình của các nhà phân tích đưa ra con số là 14 nghìn tỷ won (10,5 tỷ USD). Điều đó cho thấy việc đóng gói tiên tiến có thể chiếm 1/10 trong số đó là ưu tiên chính.

Trong một cuộc phỏng vấn oong Lee cho biết: “50 năm đầu tiên của ngành công nghiệp bán dẫn là về mặt tiền tuyến hoặc thiết kế và sản xuất các con chip cũng như chính nó. Nhưng 50 năm tới sẽ là tất cả về back-end” hay còn gọi là bao bì.

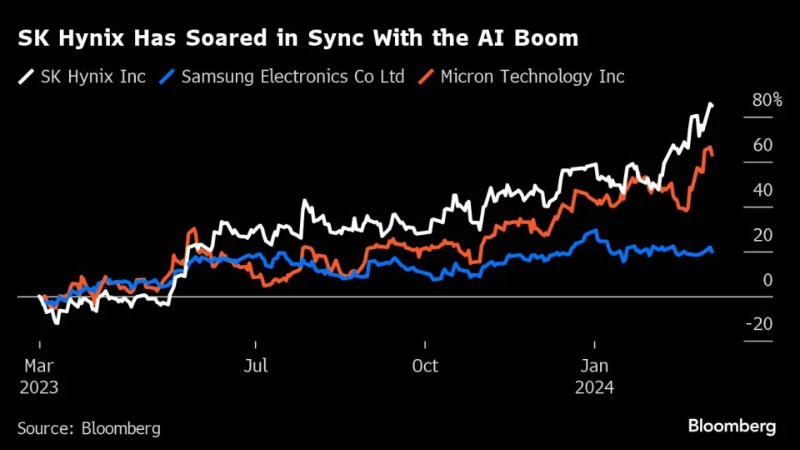

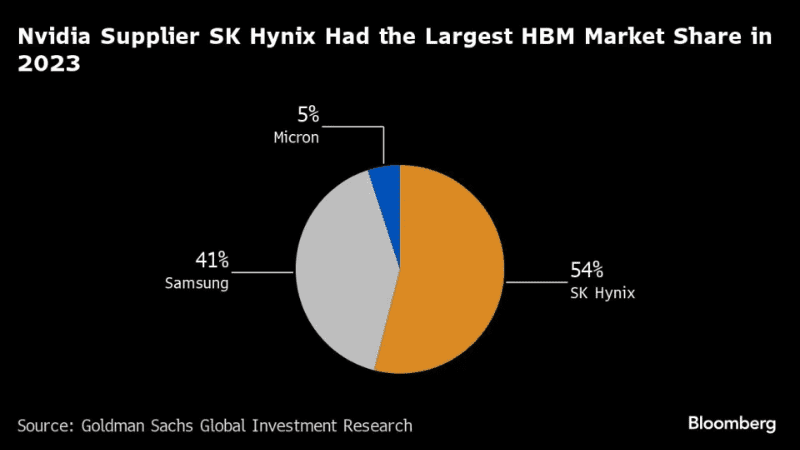

Việc trở thành người đầu tiên đạt được cột mốc tiếp theo trong cuộc đua này giờ đây có thể đưa các công ty lên vị trí dẫn đầu ngành. SK Hynix đã được Nvidia Corp. chọn để cung cấp HBM cho các máy gia tốc AI thiết lập tiêu chuẩn của mình, đẩy giá trị của công ty Hàn Quốc lên tới 119 nghìn tỷ won. Cổ phiếu của công ty đã tăng khoảng 1% tại Seoul vào thứ Năm, tăng thêm gần 120% kể từ đầu năm 2023. Đây hiện là công ty có giá trị thứ hai của Hàn Quốc, vượt trội so với Samsung và đối thủ Micron Technology Inc của Mỹ.

Việc trở thành người đầu tiên đạt được cột mốc tiếp theo trong cuộc đua này giờ đây có thể đưa các công ty lên vị trí dẫn đầu ngành. SK Hynix đã được Nvidia Corp. chọn để cung cấp HBM cho các máy gia tốc AI thiết lập tiêu chuẩn của mình đẩy giá trị của công ty Hàn Quốc lên tới 119 nghìn tỷ won. Cổ phiếu của công ty đã tăng khoảng 1% tại Seoul vào thứ 5 (07/03/2024) tăng thêm gần 120% kể từ đầu năm 2023. Đây hiện là công ty có giá trị thứ hai của Hàn Quốc, vượt trội so với Samsung và đối thủ Micron Technology Inc của Mỹ.

Ông Lee Kang Wook hiện 55 tuổi, đã giúp đi tiên phong trong một phương pháp mới để đóng gói thế hệ công nghệ thứ ba HBM2E. Phương pháp này nhanh chóng được hai nhà sản xuất lớn khác làm theo. Sự đổi mới đó là trọng tâm giúp SK Hynix giành được Nvidia với tư cách là khách hàng vào cuối năm 2019.

Việc xếp chồng các con chip để đạt được hiệu suất cao hơn từ lâu đã là niềm đam mê của Lee. Năm 2000, ông lấy bằng Tiến sĩ về công nghệ tích hợp 3D cho các hệ thống vi mô tại Đại học Tohoku của Nhật Bản dưới sự hướng dẫn của Mitsumasa Koyanagi – người đã phát minh ra DRAM tụ điện xếp chồng được sử dụng trong điện thoại di động. Năm 2002, Lee gia nhập với tư cách là kỹ sư chính tại bộ phận bộ nhớ của Samsung nơi ông lãnh đạo việc phát triển công nghệ đóng gói 3D dựa trên Silicon Via (TSV).

Công việc đó sau này trở thành nền tảng để phát triển HBM. HBM là một loại bộ nhớ hiệu suất cao xếp chồng các chip lên nhau và kết nối chúng với TSV để xử lý dữ liệu nhanh hơn và tiết kiệm năng lượng hơn.

Nhưng quay trở lại thời kỳ tiền điện thoại thông minh Samsung đã đặt cược lớn hơn vào những lĩnh vực khác. Và thông lệ là các nhà sản xuất chip toàn cầu phải gia công cho các quốc gia châu Á nhỏ hơn các nhiệm vụ lắp ráp, thử nghiệm và đóng gói chip.

Vì vậy, khi SK Hynix và đối tác Hoa Kỳ Advanced Micro Devices Inc. giới thiệu HBM ra thế giới vào năm 2013 họ vẫn không bị thách thức trong hai năm trước khi Samsung phát triển HBM2 vào cuối năm 2015. Lee gia nhập SK Hynix ba năm sau đó họ nói đùa với một chút tự hào rằng HBM là viết tắt của “Hynix’s Best Memory”.

Sanjeev Rana – nhà phân tích tại CLSA Securities Korea cho biết: “Ban lãnh đạo của SK Hynix có hiểu biết sâu sắc hơn về hướng đi của ngành này và họ đã chuẩn bị tốt. Khi cơ hội đến họ nắm lấy nó bằng cả hai tay”. Về phần Samsung “họ đã bị bắt quả tang đang ngủ trưa”.

Việc ChatGPT ra mắt vào tháng 11 năm 2022 là thời điểm mà Lee đã chờ đợi. Vào thời điểm đó nhóm của ông đã phát triển một phương pháp đóng gói mới gọi là vật liệu lót đúc nóng chảy lại hàng loạt (MR-MUF) được hỗ trợ bởi những người liên hệ của ông ở Nhật Bản. Quá trình này bao gồm việc bơm và sau đó làm cứng vật liệu lỏng giữa các lớp silicon giúp cải thiện khả năng tản nhiệt và năng suất sản xuất. Theo một người quen thuộc với vấn đề này, SK Hynix đã hợp tác với Tập đoàn Namics tại Nhật Bản về vật liệu và bằng sáng chế liên quan.

Lee cho biết SK Hynix đang rót phần lớn khoản đầu tư mới của mình vào việc thúc đẩy công nghệ MR-MUF và TSV.

Samsung vốn đã bị phân tâm trong nhiều năm bởi câu chuyện kế vị ở đỉnh cao giờ đây đang phải chống trả. Nvidia năm ngoái đã đồng ý sử dụng chip HBM của Samsung và công ty có trụ sở tại Suwon cho biết vào ngày 26 tháng 2 rằng họ đã phát triển thế hệ công nghệ thứ năm là HBM3E với 12 lớp chip DRAM và dung lượng lớn nhất trong ngành là 36GB.

Cùng ngày Micron có trụ sở tại Boise, Idaho đã gây ngạc nhiên cho những người theo dõi ngành khi cho biết họ đã bắt đầu sản xuất số lượng lớn HBM3E 24GB, tám lớp, sẽ là một phần của các đơn vị H200 Tensor Core của Nvidia được vận chuyển trong quý hai.

Với cam kết lớn về việc mở rộng và nâng cao công nghệ trong nước cũng như dự kiến xây dựng cơ sở đóng gói tiên tiến trị giá hàng tỷ đô la ở Mỹ Lee vẫn lạc quan về triển vọng của SK Hynix trước sự cạnh tranh ngày càng gay gắt. Ông coi khoản đầu tư hiện tại là nền tảng để đáp ứng nhiều nhu cầu hơn cho các thế hệ HBM trong tương lai.

English

English